Publikacja została napisana okiem socjologa, którego zasób językowy jest na tyle bogaty, że książka jest ciężkostrawna przy dłuższym czytaniu. Autor w wylewny sposób opisuje kolejne terminy związane z wyszukiwarkami, często cytując lub opierając się na badaniach innych osób (20 stronicowa bibliografia). Niestety jak na 220 stronicową pozycję, zawiera mało terminów technicznych, natomiast autor skupia się przede wszystkim na opisaniu fenomenu samych wyszukiwarek – pod względem socjologicznym, psychologicznym, itd. Z własnego doświadczenia posiadam już wiedzę na temat wyszukiwarek, więc ta pozycja niestety mnie nie oczarowała. Moim zdaniem ciekawszy jest artykuł na wstępie pana Bendyka.

Przejdźmy jednak do konkretów, czyli do samej książki (spis treści jest umieszczony w poprzednim wpisie):

1. Wyszukiwarki

O tym, że w Polsce mamy do czynienia z monopolizacją Google (98% wyszukiwania), sami dobrze wiemy. Jeżeli natomiast bierzemy pod uwagę cały świat, to ta wyszukiwarka również jest niekwestionowanym liderem (53,3% wyszukiwania w 2007 roku). W USA częściej korzysta się z mało popularnego u nas Yahoo, a w Chinach z wyszukiwarki Baidu. Właśnie Yahoo oraz MSN/Live to kolejne wyszukiwarki w rankingu popularności. Mimo przewagi innych wyszukiwarek w USA i w Chinach, to nadal supremacja Google jest niepodważalna – według prognoz długo jeszcze nikt jemu nie zagrozi (mimo starań Microsoftu i jego wyszukiwarki z 2005 roku.

Oczywiście autor bierze pod lupę samo pojęcie “wyszukiwarki” i rozumie je jako cyfrowe przechowywanie danych w postaci bibliotek. Kolejnym punktem książki jest zasada działania wyszukiwarek, czyli wyświetlanie zaindeksowanych listy wyników. Zaindeksowana ilość wyników jest bardzo duża i niemożliwa do ogarnięcia dla internauty. Sami jednak wiemy, że często strony są tworzone tylko po to, aby trafiały na nie “crawlery” (roboty) wyszukiwarek, a nie “żywy” użytkownik. Takie strony mogą mieć zastosowanie pomocnicze, które linkują do stron docelowych = pozycjonowanie. Pomimo bardzo dużej ilości zaindeksowanych stron www, wyszukiwarki nadal mają problemy z indeksowaniem stron dynamicznych. Co prawda dodatki we Flashu czy Javascript coraz lepiej się indeksują, ale część wyników jest niedostępna dla wyszukiwarek. Z taką sytuacją mamy do czynienia np. przy ciągle zmieniającej się rezerwacji biletów lotniczych lub na wydarzenie sportowe. Czasami jednak dynamiczna część strony umyślnie nie jest udostępniana dla wyszukiwarek – jest dostępna tylko dla zalogowanych użytkowników. Indeksacja stron dynamicznych z biegiem czasu powinna być coraz skuteczniejsza, a Google coraz lepiej interpretuje strony z małą ilością “czystego” htmla. Niektórzy pragną być niezależni od Googla jak np. Facebook.

Co do samej indeksacji, to zanim do niej dojdzie twórca strony musi utworzyć hiperłącza do swojej strony internetowej, tak aby “crawlery” Google mogły “zauważyć” tą stronę. Innym sposobem jest ręczne dodanie strony w formularzu zgłoszenia strony do Google (http://www.google.pl/addurl).

Trochę historii:

Samo pojęcie “wyszukiwania”, rozumianego głównie jako segregowanie materiałów bibliotecznych istniało już na początku tego wieku. Historia wyszukiwarek internetowych została zapoczątkowana jeszcze przed erą globalnej pajęczycy, w “Wczesnym Internecie” i były związane z katalogowaniem plików na serwerach FTP. “Archie” z 1990 roku grupował takie pliki, nie zwracając jednak uwagi na ich zawartość. Kolejne katalogi (“System Gopher” i “Veronica”) były już bardziej skuteczne. Pierwsza wyszukiwarka w dobie Internetu to “Wandex” pod przeglądarkę “Mosaic” z 1993 roku, czyli w dwa lata po zapoczątkowaniu stron www. W rok później tych wyszukiwarek było już kilka, a ich liczba coraz bardziej rosła.

W 1998 roku Larry Page i Sergey Brin stworzyli opartą na Page Ranku wyszukiwarkę Google, która dzieli i rządzi do dzisiaj. Microsoft także stara się współzawodniczyć w dziedzinie wyszukiwarek, tworząc w 2005 roku MSN Search (następnie MSN Live).

2. Wyszukiwanie

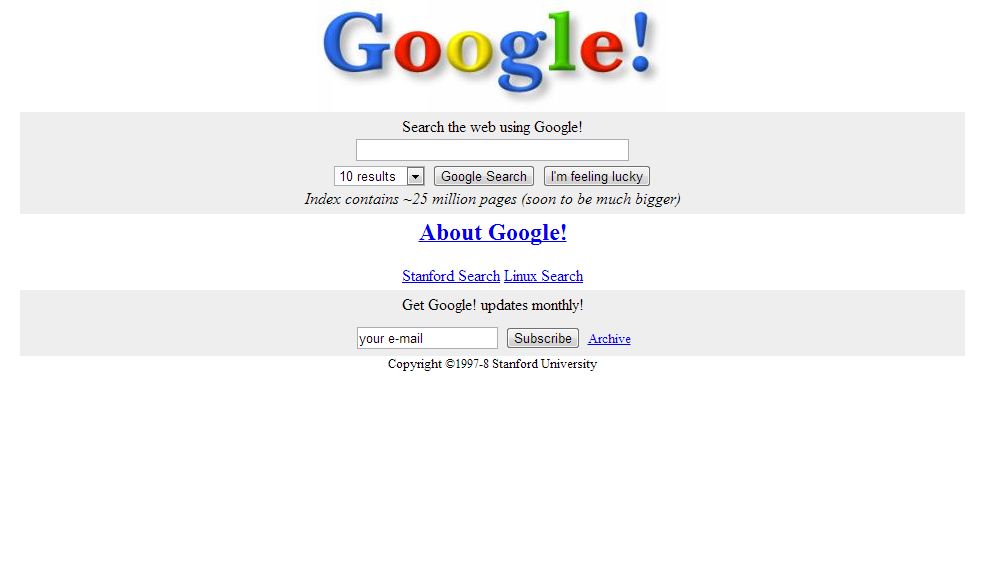

Jak powinien wyglądać interfejs wyszukiwarki? Okazuje się, że sama kompozycja graficzna wyszukiwarki internetowej jest najczęściej prosta tj. w Google. Interfejs w wyszukiwarkach powinien być prosty i nie odwracać uwagi internauty od pola wyszukiwania. Bardzo dobrym przykładem jest Google. 11.11.1998 zadebiutowało na rynku, a interfejs pierwszej wersji wcale nie odbiegał zdecydowanie od wersji obecnej. Oczywiście same algorytmy wyszukiwania uległy zdecydowanej poprawie, a Google udostępnia również inne narzędzia wyszukiwarkopodobne i nie tylko.

Google kiedyś:

A to jak wygląda główna strona wyszukiwarki Google, to już chyba każdy wie z autopsji:

Obecnie można wyszukiwać informacje w wyszukiwarkach bez wchodzenia na stronę główną wyszukiwarki. W przeglądarce internetowej w formie dodatku możemy zainstalować wyszukiwarkę lub ustawić domyślną w formie małego pola wyszukiwania. Dobrym pomysłem jest też od pewnego czasu możliwość wpisania żądanej frazy w miejscu wpisywania adresu url – domyślna wyszukiwarka wyświetla wtedy takie strony.

Autor nie mógł pominąć znaczenia idealnej wyszukiwarki tzn. takiej, która odczytuje myśli użytkownika. Okazuje się, że wraz z wprowadzeniem personalizacji wyników coraz bardziej zbliżamy się do tego pojęcia. Wyniki coraz bardziej odpowiadają naszym oczekiwaniom. Niestety jednocześnie tracimy własną osobowość. Więcej o tym pisałem w poprzednim artykule. Tutaj jednak dowiadujemy się o metodzie inwigilacji poprzez prowadzenie tzw. dziennika transakcji (TLA – ang. Transaction Log Analysis) dla stron internetowych. Wyszukiwarka analizuje ruch sieciowy i dostosowuje w ten sposób strony pod użytkownika – użytkownik jest stale śledzony :).

Jak korzystać z wyszukiwarki internetowej?

Często szukając czegoś w Internecie sami nie wiemy, czego dokładnie szukamy. Wpisujemy pierwszą frazę, a później ją modyfikujemy. Musimy to zrobić, aby uzyskać oczekiwane rezultaty – wszystko odbywa się metodą prób i błędów. Doświadczeni użytkownicy potrafią uzyskać konkretne wyniki szybciej, dobierając lepsze frazy w zależności od problemu do rozwiązania. Niestety często zadowalamy się pierwszymi lepszymi wynikami, spełniającymi nasze wymagania i nie próbujemy znaleźć lepszych. “Google whacking” to ciekawy przypadek poszukiwania takich fraz, dla których znajdziemy tylko jedną stronę. Dla typowych fraz ilość wyświetlanych stron już dawno przekroczyła ilość kilku milionów – szczególnie dla fraz angielskojęzycznych.

W 1998 roku przeprowadzono badania, z których wynikało, że tylko niecałe 2% stron internetowych indeksuje się we wszystkich ważniejszych wyszukiwarkach. Są to oczywiście wyniki dla USA. Monopolizacja Google w Polsce wyklucza sens dodawania stron pod inne wyszukiwarki.

Ciekawsze pojęcia związane z wyszukiwarkami:

- Bookmarking, czyli dodanie strony do ulubionych to najprostszy sposób na ponowne odnalezienie strony do której będziemy chcieli w przyszłości powrócić.

- W niektórych wyszukiwarkach (do niedawna w Google) można było zobaczyć strony podobne do strony, która nas interesuje – usługa dostępna w wynikach wyszukiwania.

- “Złoty trójkąt Google“, czyli jak użytkownik patrzy na listę wyników wyszukiwania. Większość z nas patrzy się na to co znajduje się po lewej stronie wyników wyszukiwań (głównie 3 pierwsze pozycje), natomiast pomija pozostałe wyniki. Tylko kilka procent osób przechodzi na kolejne strony wyszukiwania. Tak samo jak na wyniki patrzymy na strony internetowe – o to miejsce szczególnie powinny zadbać sklepy internetowe i nie tylko.

- Błędy ortograficzne w pytaniach – Google proponuje ich poprawienie, biorąc pod uwagę częściej wyszukiwaną frazę (bez błędu)

- Użytkownik może dostosować indywidualnie interfejs wyszukiwarki do własnych potrzeb (opcja do niedawna dostępna również w Google)

- “Wikipedestrian” – użytkownik wprowadzający coraz nowe hasło w wyszukiwarce Wikipedii, otwierając przy tym nowe okna. Otwiera przy tym do kilkudziesięciu podstron z powiązanymi frazami.

- Biorąc pod uwagę popularność serwisów społecznościowych nie dziwi, że duży procent użytkowników stworzyło treść do umieszczenia w sieci (44% w 2004 roku)

Jest to niewątpliwie jeden z ciekawszych rozdziałów tej książki.

3. Uwagi

O sposobach linkowania na podstawie spam tekstu lub spam stron już pewnie każdy słyszał. Jak więc wygląda typowy spam na stronach:

- “Spamdexing” – słowa kluczowe poupychane na stronie, napisane małą czcionką lub przysłonięte warstwą lub obrazkiem. To, że użytkownik ich nie widzi na stronie, nie znaczy że nie jest widoczny dla wyszukiwarek – Google analizuje czysty html, a nienaturalna ilość powtarzających się słów grozi nałożeniem filtra lub zbanowaniem strony. Inną sposobą spamdexingu jest podmiana stron – użytkownik widzi inną stronę, a wyszukiwarka inną. Duża ilość słów kluczowych odgrywa coraz mniejszą rolę w dobrym pozycjonowaniu stron – słowa powinny być m.in. umieszczone w kontekście (w tekście).

- Farmy linków – słabej jakości linki, nie przekazujące dużej ilości “Googlesoku”

- Splogi – spamblogi (np. “precle” w WordPressie) z systemami wymiany linków

- Spam w komentarzach blogów i forów – blogerzy chronią się przed spamem programami antyspamerskimi (np. Akismet), a komentarzom automatycznie przypisuje się argument “nofollow” (“proszę nie śledzić”)

- “Google bowling” – nieczysta konkurencja, działająca na niekorzyść innej firmy – farmy linków z bezpośrednim odnośnikiem do konkurencyjnej firmy

- White SEO – tworzenie stron zgodnych z wytycznymi Googla, ale czy linkowanie może być naturalne?

W związku z działaniem firmy w Internecie nie należy zapominać o Google Adwords (kampanie linków sponsorowanych) i Google AdSense (reklama banerowa). Google AdSense działa na zasadzie Pay Per Click (PPC), w której płaci się za każdego użytkownika klikającego w link lub baner. Niestety często internauci wietrząc chęć zysku tworząc tzw. strony “pasożyty”, nastawione tylko i wyłącznie na zysk.

Ideą i w ogóle podstawą istnienia Internetu miała być transparentność materiałów w sieci. Bez wykupowania licencji można było mieć dostęp do każdego materiału, poczynając od książek, a kończąc na materiałach audio i wideo. Niestety (lub stety) publikowanie materiałów w Internecie nie może naruszać praw autorskich. Samo Google chcąc rozpowszechniać książki na Google Książki i udostępnić je użytkownikowi, musi ją najpierw zeskanować – jak wiadomo takie działania są niezgodne z prawem.

4. Wiedza a demokracja

Samozadowolenie (strategia “satisfice“) z pierwszego potencjalnie, dobrego wyniku – jest to wada wielu użytkowników. Często nie wykraczamy poza pierwszą stronę wyników – dlatego tak wielu firmom zależy na miejscu w pierwszej “10” i rozwój branży SEO. Sami jesteśmy sobie winni przez nasz brak czasu. Oczywiście istnieją również skuteczni poszukiwacze, którzy bazując na doświadczeniu coraz lepiej potrafią wyszukiwać informacje wysokiej jakości. Przyjmuje się, że amerykańscy użytkownicy posiadają wyższe umiejętności wyszukiwania – związane jest to z rozwojem wyszukiwarek amerykańskich. Google oraz inne wyszukiwarki z USA są nastawione na amerykański styl życia i porozumiewania się, narzucając ten sposób krajom całego świata (Google). Zacierają się różnice kulturowe wskutek rosnącej amerykanizacji życia. Taki sposób rozumowania jest normalny, szczególnie gdy dowiadujemy się, że podczas wyszukiwania dominuje myślenie grupowe, w którym jednostki nie wybijają się ponad innych.

Specjalista od wyszukiwania czyli tzw. intelektualista wyszukiwania to osoba łącząca umiejętności techniczne ze znajomością interfejsu wyszukiwarek oraz przenikliwością. Najwybitniejsi z nich to osoby, którzy wykorzystuje je w swojej pracy i należą do nich analitycy wywiadu, eksperci giełdowi czy detektywi. Muszą więc posiadać również umiejętności wysokiej infiltracji danych. Natomiast do wyszukiwania danych najbardziej nakłaniają nauczyciele, dziennikarze czy uczeni.

Jaka wyszukiwarka mogłaby być konkurentem dla Google? Yahoo kilka lat temu opracował eksperymentalną wyszukiwarkę Mindset, w której wyniki były filtrowane w zależności od działu, w którym by się znajdowały. Strony można podzielić np. na sklepy internetowe, strony naukowe i inne. Skromniejszym pomysłem są filtrujące dane metawyszukiwarki.

Wyszukiwarki posiadają bardzo dużo zalet, natomiast ich największa wada to czasami zbyt długi czas lub wręcz niemożliwość uzyskania przez internautę wartościowych danych na określone frazy. Niestety często wyszukiwarki unikają pozyskiwania osób z “długiego ogona” na frazy o niższej poszukiwalności. Dobrym przykładem jest rynek książek, gdzie czasami wręcz niemożliwe jest zdobycie bardzo dobrych książek, które nie są po prostu rozreklamowane.

5. Cenzura

Główny slogan Google – “Don’t be evil” (“Nie czyń złego”) dotyczy oczywiście publikowania wątpliwych moralnie treści w Internecie. Z drugiej strony pojęcie cenzury często jest przez Google nadużywane przy niewłaściwym pozycjonowaniu strony (filtr lub ban dla strony). Kraje oraz wielkie firmy starają się ingerować w wyniki w wyszukiwarkach. Niektórym nie odpowiada wyświetlanie stron wątpliwych moralnie na niektóre frazy. Należy przyjąć, że wysokie pozycje są uzależnione od algorytmu wyszukiwarki – mimo tego czasami budzą one kontrowersje (wysoka pozycji strony antysyjonistycznej na frazę “Jew” – “Żyd”) . Google ulega więc niektórym krajom (USA, Chiny, Francja) wprowadzając filtrowanie wyników lub ich kontrolowanie.

Niektóre strony internetowe zarzucały Google łamanie praw autorskich przez indeksowanie ich stron, które miały być dostępne dla zalogowanych użytkowników. Takie postępowanie jest oczywiście śmieszne i wynika z nieograniczania dostępu robotów do konkretnych stron.

Interesujące i zarazem śmiesznie brzmi zawarcie w USA ustawy DMCA (ang. Digital Millenium Copyright Act) oraz rozsyłanie przez amerykańskie instytucje zakazu rozpowszechniania materiału, które łamią amerykańskie prawo. Nie byłoby w tym nic dziwnego, gdyby zakazy te nie byłyby rozsyłane po całym świecie.

6. Prywatność

Niestety w naszą osobistą przestrzeń coraz bardziej ingerują przeglądarki, wyszukiwarki i strony internetowe. Musimy zdawać sobie sprawę, że w Internecie nie jesteśmy anonimowi. Co więc zaburza naszą prywatność:

-

“Dataveillance” (obserwacja danych) – inwiligowanie osoby przez gromadzenie danych np. z zakupów internetowych, aktywności itnernetowej

-

“Sausveillance” (obserwacja z dołu) – forma kontroli, polegająca na nagrywaniu innych osób

-

“Reciprosali transparency” (wzajemna przejrzystość) – oberwowanie osób obserwujących

-

Uważaj na portale społecznościowe – to jak przedstawiasz siebie w sieci, może być ważne np. dla rekruterów

-

Nie mamy kontroli nad prawdziwością danych o nas, szczególnie gdy ktoś, chce nam zrobić na złość

-

Fałszywa tożsamość – jeżeli na stronie jest wymagane zarejestrowanie się, to często podajemy nieprawdziwe dane lub podajemy tylko nasz pseudonim. Korzystając z witryny Bugmenot możemy skorzystać ze sprawdzonych, fałszywych tożsamości – przerażające prawda? Ta tożsamość zasłużyła na własną nazwę – “sockpuppet” czyli skarpetowa kukiełka 🙂

7. Wyszukiwarki społecznościowe

Blogi, fora, portale społecznościowe – tutaj można wypromować swoją stronę. Coraz większa ilość profilów firmowych na Facebooku mówi sama za siebie. W ten sposób możemy również uzyskać cenne dla nas linki.

8. Pogoń za przyszłością

Co nam przyniesie przyszłość? Można spodziewać się coraz większej ingerencji w naszą prywatność wskutek rozwoju personalizacji. Poza tym w najbliższej przyszłości może nastąpić:

- Wyszukiwarka jako sposób na znajdowanie nie tylko miejsc, ale również ludzi (gdzie się znajdują?)

- Coraz większe zawężanie danych, po uwzględnianiu naszych danych

- Coraz lepsze technologie rozpoznawania charakteru pisma oraz ich indeksowanie w wyszukiwarkach

- Cyfryzacja treści książkowych, audio oraz wideo

- Identyfikacja osoby na podstawie twarzy na wideo lub zdjęciach. Rozwój technologii Systemu Monitoringu Audycji, polegającego na wykrywaniu mowy i jej tłumaczeniu.

- Ciągły rozwój kartografii internetowej (Google Street View)

- 23andme – szalony projekt googlowski, zbierający informacje o DNA użytkowników

- Szukanie zgubionych rzeczy przez Google, nanosząc na nią znaczniki RFID

- Second Life

- Life logi czyli życiowe blogi (opisany lub wyemitowany każdy moment z życia autora bloga)

- Ludzki interfejs wyszukiwarki, podpowiadający i odpowiadający na pytania

- Interaktywne wyświetlacze graficzne jako interfejs wyszukiwarki

- Przejrzyste wyszukiwarki z akceptacją robotów googlowskich – crawlerów

- Google będzie dzielić i rządzić jeszcze przez długi czas

Podsumowanie:

Osobiście uważam, że książka jest warta lektury – przede wszystkim trzech pierwszych rozdziałów oraz tego ostatniego. Niestety wiele rzeczy zostało przegadanych (całkowicie niestrawny rozdział o wyszukiwarkach społecznościowych), ale ogólnie uznałem książkę za dobrą (z lekkim minusem za niestrawność).

W tej książce każdy może znaleźć coś dla siebie, ale bardziej zaawansowanym internautom raczej go nie polecam – zbyt dużo nieaktualności i ogólników.

Obecnie przerzuciłem się na lekturę “letnią”, ale na jesień planuję zamieścić opis jednej z książek na temat e-marketingu.

Cześć, Dominiku,

Oprócz tłumaczeń zajmuję się też marketingiem internetowym, podobnie jak Ty. Przypadkiem znalazłam Twój artykuł i wielkie Ci za niego dzięki. Wcześniej nie słyszałam o tej książce (ba! nawet o autorze!), ale zaintrygował mnie do tego stopnia, że jestem ciekawa, co jeszcze Alexander miał do powiedzenia. W sumie tyle mam do powiedzenia. Tak więc: dzięki!

Pzdr.

A.

Anna ostatnio opublikował…Englisz – funny mistranslations and anglicisms in Warsaw, Poland